Se il tuo sito non viene indicizzato, è essenzialmente non letto da Google e dagli altri motori di ricerca che stanno acquisendo importanza come Bing. E se i motori di ricerca non riescono a trovare e leggere una pagina, nessuna magia per quanto grande oppure ottimizzazione dei motori di ricerca (SEO) migliorerà la classifica delle tue pagine web.

Per essere classificato, un sito deve prima essere indicizzato.

Il tuo sito viene indicizzato?

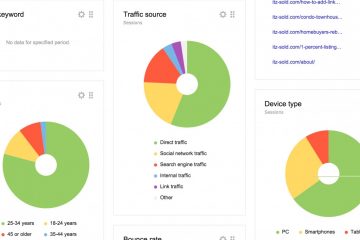

Ci sono molti strumenti disponibili per aiutarti a determinare se un sito è stato indicizzato o meno. L’indicizzazione è, al suo interno, un processo a livello di pagina. In altre parole, i motori di ricerca leggono pagina per pagina e le trattano singolarmente. Un modo rapido per verificare se una pagina viene indicizzata da Google è utilizzare il sito stesso: puoi infatti verificarlo con una ricerca su Google. Inserendo solo il dominio, come nel mio esempio qui sotto, ti verranno mostrate tutte le pagine che Google ha indicizzato per quel dominio. Puoi anche inserire un URL di pagina specifico per vedere se quella singola pagina è stata indicizzata.

Quando una pagina non è indicizzata

Se il tuo sito o la pagina non vengono indicizzati, nella maggior parte dei casi il colpevole più comune è il tag meta robots utilizzato su una pagina oppure l’uso improprio che ne viene fatto e che pone divieti e paletti nel file robots.txt. Sia il meta tag, che si trova a livello di pagina, sia il file robots.txt forniscono istruzioni ai robot di indicizzazione dei motori di ricerca su come trattare i contenuti della tua pagina o del tuo sito web. La differenza è che il meta tag robots viene visualizzato su una singola pagina, mentre il file robots.txt fornisce istruzioni per il sito più in generale nel suo complesso. Nel file robots.txt, tuttavia, è possibile individuare le pagine o le directory e il modo in cui i robot devono trattare queste aree durante l’indicizzazione. Esaminiamo come utilizzare ciascuno di questi elementi.

Robots.txt

Se non sei sicuro che il tuo sito utilizzi un file robots.txt, c’è un modo semplice per scoprirlo con certezza. Inserisci semplicemente il tuo dominio in un browser seguito da /robots.txt. Ecco un esempio utilizzando Amazon (https://www.amazon.com/robots.txt)

L’elenco di “disallows” per Amazon è un bel po’ lungo e complesso! Google Search Console dispone anche di uno strumento robots.txt Tester utile, che consente di identificare gli errori nel file dei robot. Puoi anche testare una pagina sul sito utilizzando la barra in basso per vedere se il tuo file robot nella sua forma attuale stia magari bloccando Googlebot.

Se una pagina o una directory sul sito non sono consentite, verranno visualizzate dopo Disallow, all’interno del file robots. Come mostra il mio esempio prima proposto, non ho autorizzato la mia pagina di destinazione (/ lp /) dall’indicizzazione usando il mio file robots. Ciò impedisce che le pagine residenti in tale directory vengano indicizzate dai motori di ricerca. Esistono molte opzioni interessanti e complesse in cui è possibile utilizzare il file dei robot. Il sito dedicato agli sviluppatori da Google ha una grande panoramica di tutti i modi in cui puoi utilizzare il file robots.txt.

Meta tag robot

Il meta tag robots viene inserito nell’intestazione di una pagina web. In genere, non è necessario utilizzare sia il meta tag robots che il robots.txt per disabilitare l’indicizzazione di una determinata pagina che non vuoi che venga trovata. Nell’immagine della Search Console che hai visto prima, non ho avuto bisogno di aggiungere il meta tag robots a tutte le mie pagine di destinazione nella cartella della pagina di destinazione (/ lp /) per impedire a Google di indicizzarle poiché non ho consentito alla cartella di indicizzare utilizzando il file robots.txt. Tuttavia, il meta tag robots ha anche altre funzioni altrettanto importanti. Ad esempio, è possibile indicare ai motori di ricerca che i collegamenti sull’intera pagina non devono essere seguiti ai fini dell’ottimizzazione dei motori di ricerca. Ciò potrebbe rivelarsi utile in determinate situazioni, come nelle pagine dei comunicati stampa.

Probabilmente le due direttive usate più spesso per il SEO con questo tag sono noindex/index e nofollow/follow:

– Index follow: implicito per impostazione predefinita. I robot di indicizzazione dei motori di ricerca dovrebbero indicizzare le informazioni su questa pagina. I robot di indicizzazione dei motori di ricerca dovrebbero seguire i link in questa pagina.

– Noindex nofollow: i robot di indicizzazione dei motori di ricerca NON devono indicizzare le informazioni su questa pagina. I robot di indicizzazione dei motori di ricerca NON devono seguire i link in questa pagina.

Il sito dello sviluppatore di Google ha anche una spiegazione approfondita degli usi del meta tag robots. Consultandoli potrai farti un’idea più precisa degli usi che puoi fare di questi meta tag.

Sitemap XML

Quando hai una nuova pagina sul tuo sito, naturalmente vorresti che i motori di ricerca la trovassero e la indicizzassero nel modo più rapido possibile. Un sistema per aiutarti in questo sforzo consiste nell’utilizzare una sitemap del linguaggio di marcatura eXtensible (XML) e registrarla nei motori di ricerca.

Le sitemap XML forniscono ai motori di ricerca un elenco di pagine sul tuo sito web. Ciò è particolarmente utile quando si hanno nuovi contenuti che probabilmente non hanno ancora molti link in entrata che puntano ad esso, rendendo più difficile per i robot dei motori di ricerca seguire un link per trovare quello specifico contenuto. Molti sistemi di gestione dei contenuti ora hanno funzionalità di sitemap XML integrate o disponibili tramite un plugin, come il plugin SEO Yoast per WordPress.

Assicurati di avere una Sitemap XML e che sia registrata con Search Console di Google e Strumenti per i Webmaster di Bing. Ciò garantisce che Google e Bing sappiano dove si trova la Sitemap e possano continuamente tornare a indicizzarla.

Con quale velocità i nuovi contenuti possono essere indicizzati utilizzando questo metodo? Una volta ho fatto un test e ho scoperto che i miei nuovi contenuti erano stati indicizzati da Google in soli otto secondi – e quello era il tempo necessario per modificare le schede del browser ed eseguire il comando site operator. Quindi è davvero molto veloce!

JavaScript

Nel 2011, Google ha annunciato di essere finalmente in grado di eseguire JavaScript e indicizzare determinati elementi dinamici che prima ignorava e non valutava. Tuttavia, Google non è sempre in grado di eseguire e indicizzare tutti i JavaScript. In Google Search Console, lo strumento Fetch e Render può aiutarti a determinare se il robot di Google, Googlebot, è effettivamente in grado di vedere i tuoi contenuti in JavaScript. Un aiuto non da poco se si considera l’importanza dei motori di ricerca e dell’ottimizzazione del processo di indicizzazione.

In questo esempio, il sito web dell’università utilizza JavaScript asincrono e XML (AJAX), che consiste in una forma speciale di JavaScript, per generare un menu specifico del corso che si collega a determinate aree di studio. Lo strumento Fetch e Render ci mostra che Googlebot non è in grado di vedere il contenuto e i collegamenti nello stesso modo in cui lo faranno gli esseri umani. Ciò significa che Googlebot non può seguire i collegamenti nel JavaScript a queste pagine di corso più approfondite del sito.

Conclusione

Da quanto detto fino ad ora e da tutti gli esempi che quotidianamente puoi verificare, penso sia molto chiara l’importanza che deve avere l’indicizzazione di un sito o di una singola pagina web per la sua classificazione. Se i motori di ricerca non riescono a trovare oppure a leggere i tuoi contenuti, come possono valutarli e classificarli? Assicurati quindi di dare la priorità alla verifica dell’indicizzazione del tuo sito quando esegui un controllo SEO. On line puoi trovare ogni tipo di strumento gratuito che ti aiuterà in questa verifica e potrai in pochi secondi verificare il tuo posizionamento on line per aumentare il tuo ranking e di conseguenza anche le tue vendite!